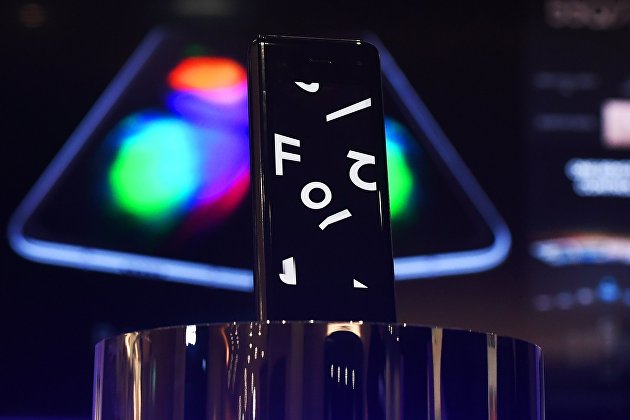

Смартфон с гибким экраном Galaxy Z Fold2 поступит в продажу в России 18 сентября

Смартфон с гибким экраном Samsung Galaxy Z Fold2 поступит в продажу в России в черном и бронзовом цветах 18 сентября, предзаказы на устройство начнутся с 1 сентября, его презентация прошла в рамках онлайн-конференции Galaxy Unpacked2.

Стоимость Galaxy Z Fold2 в России составит 179 990 рублей. Предварительные заказы на устройство можно будет оформить в официальном интернет- и фирменных магазинах бренда, а также у партнеров. Пользователям также доступен комплекс специализированных сервисных услуг и сертификат Samsung Care+.

Смартфон имеет 6,2-дюймовый внешний экран Infinity-O, что позволяет смотреть контент без необходимости раскрывать смартфон, а также большой 7,6-дюймовый основной дисплей с частотой обновления 120 Гц. Основной экран выполнен из ультратонкого стекла Ultra Thin Glass. Внутри зазора между шарниром и корпусом Galaxy Z Fold2 есть микрощетки, предотвращающие попадание пыли и мелких частиц под дисплей. Кроме того, смартфон оснащен двойными динамиками с усовершенствованным стереоэффектом и более четким звучанием.

В устройстве представлена 10-мегапиксельная селфи-камера и 12-мегапиксельная тройная основная камера. Смартфон также имеет аккумулятор емкостью 4500 мАч с режимом быстрой проводной и беспроводной зарядки, процессор Snapdragon 865+. Операционная система смартфона — Android 10. Оперативная память составляет 12 ГБ, объем памяти — 256 ГБ.