Исследователи создают ИИ-ученых

Исследователи разрабатывают искусственный интеллект, способный самостоятельно формулировать гипотезы, проводить эксперименты и писать научные статьи.

Разница между учеными, использующими ИИ, ИИ-учеными и «ИИ-учеными»

Есть множество примеров того, как ученые используют ИИ. Один из них — исследование MIT в 2019 году. Тогда ИИ обучили на базе 1700 одобренных FDA (Управление по контролю за продуктами и лекарствами США) препаратов и 800 природных веществ, многие из которых были антибиотиками или обладали антибактериальными свойствами. ИИ проанализировал библиотеку из 6000 соединений, чтобы найти новое вещество с аналогичными свойствами. Так был обнаружен антибиотик Halicin. В 2023 году та же команда нашла второй антибиотик, который может быть эффективен против MRSA, устойчивой к антибиотикам бактерии.

Обычно термин «ИИ-учёный» означает специалиста, который глубоко разбирается в ИИ, таких как большие языковые модели или искусственные нейронные сети. Однако всё чаще этот термин также используется для обозначения нового вида ИИ, который работает как учёный. Пока что этот ИИ-учёный изучает только модели ИИ, что делает его одновременно и ИИ-экспертом, и «ИИ-учёным» в прямом смысле.

ИИ-учёный

Японская компания Sakana AI финансирует лабораторию в Университете Британской Колумбии и Оксфордском университете для разработки ИИ, который сможет выполнять весь научный процесс самостоятельно. Этот ИИ должен изучать научную литературу, формулировать гипотезы, проводить эксперименты, писать научные статьи и проверять свои же работы на соответствие исходной научной литературе.

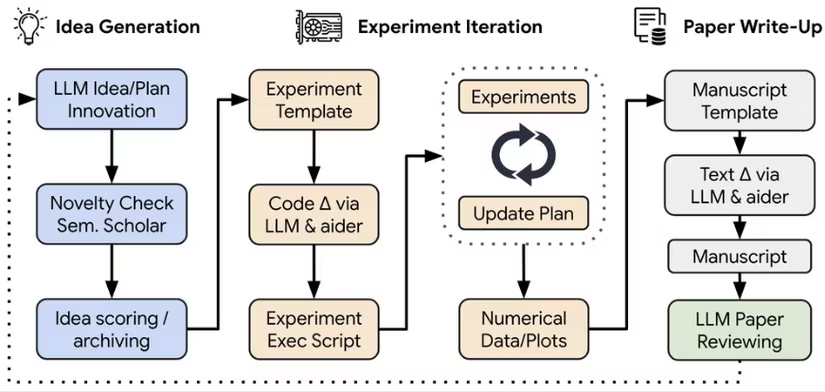

Чтобы снизить вероятность ошибок, команда Университета Британской Колумбии разработала пошаговый процесс, который ИИ должен следовать. ИИ получает данные о модели ИИ или типе ИИ и выдвигает несколько гипотез о том, как можно улучшить данную модель. Он оценивает идеи на основе их «интересности, новизны и осуществимости». После выбора гипотезы ИИ проверяет базы данных, чтобы убедиться, что идея действительно нова и оригинальна. Затем он использует программу-помощника для написания кода и тестирования гипотезы, параллельно ведя исследовательские записи. Если необходимо, он проводит дополнительные эксперименты и пишет научную статью.

На финальном этапе ИИ оценивает статью и может отклонить её, если обнаружит сфабрикированные данные или «галлюцинации» — ошибочные выводы, характерные для некоторых моделей ИИ. Один из исследователей признался, что им удалось снизить количество галлюцинаций только до десяти процентов. «Мы считаем, что десять процентов — это всё равно неприемлемо».

Возможные недостатки

Одна из распространённых проблем в ИИ — это предвзятость, связанная с популярностью. Исследователи также заметили эту проблему у ИИ-учёного: он может отдавать предпочтение областям, которые уже были хорошо изучены, или слишком высоко оценивать теории, на которые собрано больше данных.

С другой стороны, ИИ может казаться более креативным, потому что у него нет интуиции или предыдущего опыта, которые могут ограничить возможности. Например, физик, изучающий квантовые частицы света, не мог в течение нескольких недель разработать способ наблюдения за определённым явлением. Подозревая, что его собственная интуиция мешает, он решил задействовать ИИ. В течение нескольких часов ИИ предложил эксперимент, который оказался успешным.

Однако отсутствие интуиции и опыта у ИИ может мешать правильной интерпретации результатов. Исследователи из Университета Британской Колумбии сравнивают его выводы с выводами начинающих аспирантов, которые склонны делать поспешные или не совсем точные заключения.

Кроме того, развитие ИИ-учёных поднимает этические вопросы.

Кто будет получать признание за работу ИИ-учёного? А кто будет нести ответственность за ошибки, плагиат или искажение данных?

Источник: habr.com