Новая технология Google может считывать язык тела без использования видеокамер

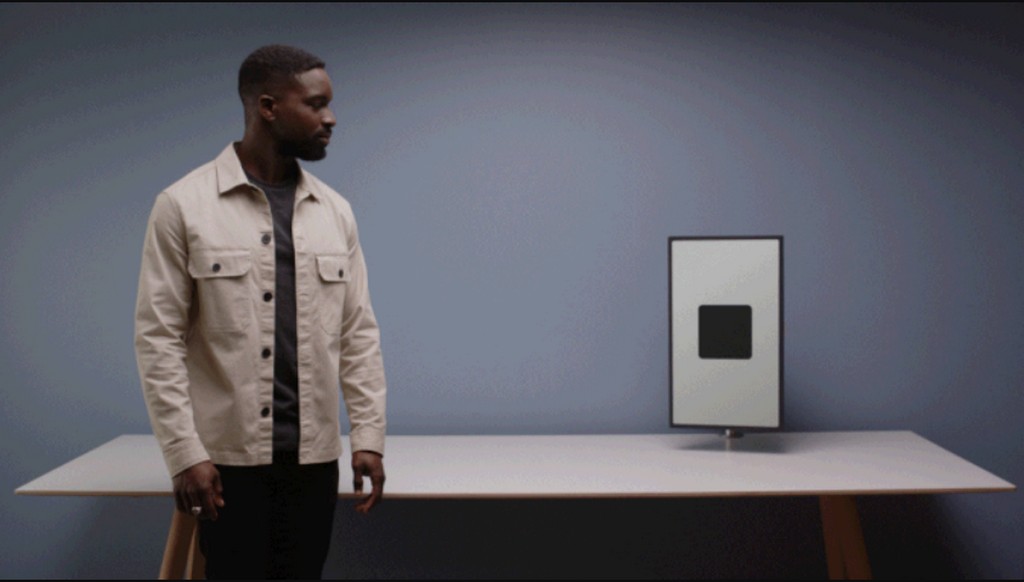

Google разрабатывает «новый язык взаимодействия» в лаборатории Advanced Technology and Projects, который позволит общаться с устройствами языком жестов.

Система ATAP анализирует движения, чтобы увидеть, готов ли человек к взаимодействию, а все остальное время работает в фоновом режиме.

Команда использовала радарный датчик Soli, чтобы определить близость, направление и маршруты людей вокруг. Затем он анализирует эти данные, чтобы определить, смотрит ли кто-то на датчик, проходит ли мимо, приближается или поворачивается к нему.

Google создала набор из четырех движений: Approach, Pass, Turn и Glance. Эти действия можно использовать в качестве триггеров для команд или реакций при взаимодействии с интеллектуальными дисплеями или другими устройствами. Некоторые из жестов уже работают на существующих устройствах с поддержкой Soli. Например, в Pixel 4 есть функция Motion Sense, которая откладывает будильник, если помахать рукой, или активирует телефон, если обнаруживает, что к нему приближается рука. Nest Hub Max от Google использует камеру, чтобы увидеть поднятую открытую ладонь, и в ответ приостанавливает воспроизведение мультимедиа.

Разработчики объясняют: функция нужна, чтобы пользователь мог переключаться между несколькими устройствами с помощью жестов.

Теперь команда ATAP работает над комбинацией некоторых действий, таких как приближение и взгляд, чтобы устройство могло реагировать и в этих ситуациях.

Глава отдела дизайна ATAP Леонардо Джусти сказал: «Это самая большая проблема, с которой мы сталкиваемся при работе с этими сигналами». Он сказал, что с подключенными устройствами есть больше возможностей для более сложных алгоритмов, чем на мобильном устройстве. Частью усилий по повышению точности системы является сбор большего количества данных для тренировки алгоритмов машинного обучения, включая правильные действия, а также похожие, но неправильные (чтобы они узнали, что не нужно принимать).

Источник: habr.com