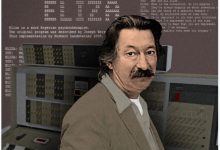

От первых «нейронок» из 80-х до ChatGPT. Как развивались языковые ИИ-модели

Популярный чат-бот ChatGPT построен на языковой модели GPT-3 от OpenAI, выпущенной в 2020-м. Основы этой технологии были заложены ещё на заре компьютерной эры. Издание MIT Technology Review поделилось историей создания нейронных сетей, работающих с естественной речью.

1980-е: первые проекты

Современные алгоритмы обработки языка функционируют за счёт обширных сетей из множества параметров. Их можно сравнить с мозговыми нейронами. Модель тренируют на крупных массивах данных, обучая отслеживать статистические закономерности в тексте. Так ИИ начинает распознавать контекст разных ситуаций, на основе чего формирует, подобно человеку, суждения.

Уже в 1980-х дебютные сети умели обрабатывать ограниченный порядок слов. Но при этом слишком долго учились и часто «забывали» предыдущие слова из последовательности. В 1997-м недостаток исправили учёные Сепп Хохрайтер и Юрген Шмидхубер. Они изобрели технологию нейронных сетей LTSM (Long Short-Term Memory), которые обрабатывали текст из несколько сотен слов и лучше «помнили» данные последовательностей. Однако их языковые навыки на тот момент всё ещё были ограниченными.

2017-2019: «трансформеры» Google

Следующий крупный прорыв в ИИ-области случился благодаря новой архитектуре нейронных сетей — Transformer. Её создали в 2017 году специалисты Google. Технология предложила ряд преимуществ, включая взаимодействие с длинными абзацами текста и улучшенное распознавание значений слов, а также связей между ними. Отслеживая контекстуальные нюансы, алгоритмы научились лучше предсказывать, какое следующее слово будет уместным в последовательности.

Спустя несколько месяцев в игру вступила компания OpenAI, представив первые поколения крупных языковых моделей: GPT и GPT-2 (Generative Pre-trained Transformer). Разработчики назвали своё детище «ключевым шагом к созданию мультизадачного, разностороннего ИИ, который способен выполнять любые языковые сценарии». Модернизировали и процесс обучения модели: данные больше не маркировали вручную, что позволило быстрее анализировать крупные объёмы информации.

2020-2022: GPT-3 и ChatGPT

С дальнейшей полировкой всех наработанных методик актуальная GPT-3 превзошла все ожидания. Значительно улучшились способности ИИ по генерации ответов на вопросы, созданию оригинальных историй, сокращению документов и переводу на различные языки. Однако прежде чем представить результат общественности, экспертам OpenAI пришлось исправить несколько важных проблем.

Одна из главных — предвзятость, возникающая из-за неконтролируемого поглощения множества сведений из интернета. Также инженеры обратили внимание на этические вопросы и в декабре 2020-го модифицировали GPT-3, чтобы та избегала противоречивых и неприемлемых ответов. Наконец, в 2022 году нейросеть показала видимый прогресс: дезинформацию и оскорбительный контент она почти не выдавала.

На основе актуальной модели OpenAI создала простого в использовании чат-бота ChatGPT и показала его публике в декабре прошлого года. Благодаря обратной связи от множества пользователей, протестировавших ИИ-помощника, большинство ошибок удалось свести к минимуму. Остальное — это уже история.

Источник: 4pda.to