Как ИИ влияет на интернет-безопасность?

Сегодня многие в своей работе активно используют искусственный интеллект для решения различных задач. Например, с помощью таких инструментов, как ChatGPT, они составляют финансовые отчеты, бухгалтерские документы и так далее. Однако при этом возникает серьезная проблема: для получения точных ответов на запросы пользователи зачастую раскрывают конфиденциальную информацию.

Рассмотрим, как ИИ влияет на корпоративную безопасность и какие меры нужно принять для защиты данных.

Корпоративная безопасность

Корпоративная безопасность — это комплекс мер, направленных на защиту организации от внутренних и внешних угроз, способных нанести ущерб данным и репутации. Эти меры включают в себя физическую и информационную безопасность, защиту интеллектуальной собственности, а также управление рисками и инцидентами.

Функции корпоративной безопасности

-

- Защита данных и информации

В эпоху технологического прогресса данные являются одним из самых ценных активов компании. Утечка конфиденциальной информации может привести к финансовым потерям и утрате доверия клиентов.

- Защита данных и информации

-

- Предотвращение финансовых убытков

Кибератаки, мошенничество и другие угрозы могут нанести серьезный ущерб финансовому положению компании. Эффективные меры борьбы помогают минимизировать риски и предотвратить убытки.

- Предотвращение финансовых убытков

-

- Соблюдение требований законодательства

Несоблюдение требований законодательства приводит к юридическим последствиям.

- Соблюдение требований законодательства

-

- Поддержка деловой репутации

Корпоративная безопасность помогает защитить репутацию компании.

- Поддержка деловой репутации

-

- Обеспечение стабильности бизнеса

Наличие качественной системы безопасности позволяет компаниям быстро реагировать на инциденты, что является ключевым фактором для обеспечения непрерывности бизнес-процессов.

- Обеспечение стабильности бизнеса

ИИ: от удобства к вопросам безопасности

Сегодня мало кого можно удивить беспилотными автомобилями, голосовыми ассистентами, рекомендациями в соцсетях и написанием текста с помощью чат-ботов. Искусственный интеллект меняет нашу жизнь, делает ее удобнее и интереснее. С каждым годом появляются новые возможности, и будущее нейросетей выглядит очень многообещающим.

Искусственный интеллект не только облегчает нашу повседневную жизнь, он также активно используется в работе. Современные AI-инструменты могут писать код, составлять планы совещаний или готовить отчеты. Это экономит время и повышает эффективность сотрудников. Например, программисты могут использовать ИИ для автоматизации рутинных задач, чтобы сосредоточиться на более сложной и творческой работе. Менеджеры доверяют нейросети планирование встреч и подготовку документов.

Однако, несмотря на все преимущества, возникает вопрос: насколько безопасно использовать искусственный интеллект в рабочих процессах?

ChatGPT стал главным продуктом в сфере искусственного интеллекта за последние пару лет. И, безусловно, это самый успешный проект OpenAI. В 2023 году в открытый доступ выложили большое исследование «Масштабируемое извлечение обучающих данных из языковых моделей». На 64 страницах группа ученых доказывает на конкретных примерах, что ChatGPT выдает рандомным пользователям огромное количество конфиденциальных данных, полностью нарушая законодательства многих стран в сфере защиты персональной информации. Американская компания OpenAI отреагировала на это исследование, заявив, что проблема устранена. Но повторные тесты показали обратную ситуацию. Не стоит думать, что сбором персональной информации «грешит» только ChatGPT. Все нейросети устроены так, чтобы для их обучения нужны были тонны данных. ИИ обучаются на информации из открытых источников. Каких именно — непонятно. Разработчики об этом умалчивают. По заявлению OpenAI, диалоги не используются при обучении нейросети, но при этом остаются в истории общения с чат-ботом и хранятся на серверах компании. Использование нейросетей в корпоративном сегменте набирает популярность, поэтому вопрос конфиденциальности данных актуален как никогда.

Виктор Попов, эксперт по ИИ, основатель и СЕО проекта BotB2B

При использовании ИИ для решения задач сотрудники часто вводят конфиденциальную информацию. Это может быть информация о компании, финансовые отчеты, клиентские базы и многое другое. ИИ-системы собирают и анализируют эти данные, а также могут использовать информацию из интернета для улучшения своих алгоритмов. Этот процесс поднимает несколько серьезных проблем.

Нейросети уязвимы. Возможность перехвата или изменения данных может привести к серьезным последствиям для частных лиц или организаций. Более того, при использовании нейросетей для обработки конфиденциальной информации возникает риск ее утечки или несанкционированного доступа. Учитывая этот фактор, мы заявляем, что предоставление нейросетям конфиденциальной информации может быть опасным.

Алексей Иёшин, автор проекта «Арт-панк от Айтишного», системный администратор с 20-летним стажем, специалист по нейросетям, амбассадор проекта «Русский код»

Работая с общедоступными сервисами искусственного интеллекта, нельзя забывать о том, что все они обучаются на данных, загружаемых пользователями. Следовательно, любая информация, полученная ИИ, может стать ответом на запрос другого пользователя.

Ваши данные, может, и не будут использованы в качестве прямых ответов на чужие запросы, однако вся загруженная информация в течение определенного количества времени хранится в неизменном виде в базе данных сервиса и доступна разработчикам. Безопасность этих данных полностью зависит от защищенности сервиса, к которому обратился пользователь.

Ксения Ахрамеева, к. т. н., ведущий инженер-аналитик компании «Газинформсервис»

Насколько безопасно раскрывать конфиденциальную информацию искусственному интеллекту

Риски, которые необходимо учитывать

- Возможность утечки данных. Чат-боты и аналитические платформы могут быть уязвимы для хакерских атак, что может привести к несанкционированному доступу к корпоративной информации.

- Отсутствие контроля над данными. При использовании сторонних ИИ-платформ компании часто теряют контроль над тем, как и где обрабатываются их данные. Это может привести к нарушению правил конфиденциальности и безопасности, особенно если данные хранятся в разных странах с разными законами о защите информации.

- Вопросы конфиденциальности. Даже если ИИ-системы защищены от внешних угроз, данные, передаваемые через эти системы, могут использоваться для обучения нейросетей с целью улучшения качества последующих ответов.

Большинство нейросетей работают, обучаясь на огромных объемах данных, включая личную информацию пользователей, такую как профессия, пол, возраст, местоположение. Это означает, что ИИ имеет доступ к конфиденциальной информации, которая может быть использована без согласия или дополнительных ограничений. Существует риск, что эти данные могут быть украдены или использованы в незаконных целях.

Алексей Иёшин, автор проекта «Арт-панк от Айтишного», системный администратор с 20-летним стажем, специалист по нейросетям, амбассадор проекта «Русский код»

Некоторые сотрудники подключаются к ИИ-сервисам в режиме инкогнито в браузере, полагая, что таким образом обеспечивают анонимность запросов. Но так ли это?

Алгоритмы обработки данных не всегда могут гарантировать полную анонимность и безопасность передаваемой информации. Для снижения этих рисков компании должны строго ограничивать объем и характер данных, передаваемых ИИ.

Сергей Толокольников, руководитель направления факультета искусственного интеллекта Университета «Синергия»

Существует ли риск утечки из баз данных ИИ

Несмотря на заверения разработчиков, базы данных ИИ-ассистентов бывают уязвимы для взлома или несанкционированного доступа.

Системы ИИ обычно разрабатываются и поддерживаются сторонними организациями. В случае недостаточной защиты или при наличии уязвимостей в системах безопасности возможны утечки информации.

Сергей Толокольников, руководитель направления факультета искусственного интеллекта Университета «Синергия»

Март 2023 года: Из-за ошибки в клиентской библиотеке Redis в ChatGPT произошла утечка данных пользователей. В результате некоторые пользователи могли видеть чужие запросы и личные данные, включая адреса электронной почты, платежные адреса и частичные номера банковских карт.

Сергей Воропаев, генеральный директор ООО «Асилиск»

ИИ-сервисы, чат-боты и приложения, которые используются для генерации новой информации на основе запросов, являются информационными ресурсами. Такими же, как почта или мессенджер. И если отправка конфиденциальной информации между чатами в компаниях обычно регламентируется NDA-соглашениями, то запреты на использование ИИ-сервисов зачастую не прописаны.

Следует напомнить сотрудникам о таком понятии, как «конфиденциальная информация». А это не только «коммерческая тайна», но и отрывочные сведения о договорах, проектах, сметах. Их разглашение ставит под угрозу деятельность компании, а виновнику грозит как дисциплинарная, так и уголовная ответственность. Если же сотрудник надеется на анонимность, то тут его ждет разочарование, так как многие ИИ-сервисы собирают и хранят информацию о пользователе, которую можно получить с помощью файлов cookie, вплоть до имени, номера телефона, IP-адреса, местоположения и т. д. Более того, эти данные при возможной утечке могут быть использованы злоумышленниками против пользователей.

Ксения Ахрамеева, к. т. н., ведущий инженер-аналитик компании «Газинформсервис»

Итак, всегда есть вероятность утечки информации из баз данных ИИ. Особенно сведений, которые могут представлять интерес для злоумышленников, например бухгалтерской отчетности или информации со статусом NDA.

Любая ИИ-система кому-то принадлежит. И где-то есть те, кто может получить доступ к информации, обрабатываемой в этой системе. Таким образом, при загрузке в подобную систему каких-либо данных осуществляется их передача от одного пользователя другим. Будь то разработчики или просто лица, обеспечивающие хостинг. Установить конечных получателей информации можно далеко не всегда. Да и не все пользователи задумываются о том, что приложение, установленное у них на устройстве, «сливает» данные куда-то еще. А значит, существенно возрастает риск передачи информации неустановленным лицам.

Василиса Скидан, консультант департамента консалтинга и аудита

Законно ли делиться конфиденциальной информацией с ИИ?

Передача конфиденциальной информации компании в запросе ChatGPT или другой LLM системы может нарушать 149-ФЗ «Об информации, информационных технологиях и о защите информации» и 98-ФЗ «О коммерческой тайне».

Сергей Воропаев, генеральный директор ООО «Асилиск»

Предоставляя ИИ-сервису конфиденциальную информацию, пользователь, скорее всего, нарушает и внутреннюю политику, и NDA-соглашения компании, в которой работает.

Согласно действующему Федеральному законодательству и Федеральному закону 152 «О персональных данных», любое раскрытие персональных данных является нарушением. Независимо, скопировали ли их на флешку и унесли домой, переслали конкурентам по почте или «слили» нейросети.

Алексей Иёшин, автор проекта «Арт-панк от Айтишного», системный администратор с 20-летним стажем, специалист по нейросетям, амбассадор проекта «Русский код»

Несоблюдение требований закона может также привести к утрате доверия со стороны клиентов и партнеров, что негативно скажется на репутации организации и бизнесе в целом.

Компании, работающие в России, обязаны обеспечивать защиту персональных данных от несанкционированного доступа и утечки. Это касается и использования систем ИИ, которые могут обрабатывать такие данные.

Сергей Толокольников, руководитель направления факультета искусственного интеллекта Университета «Синергия»

Рекомендации для бизнеса

Использование ИИ открывает новые возможности для бизнеса, но также требует особого внимания к вопросам безопасности и защиты данных.

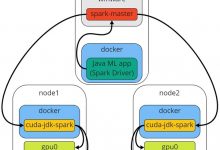

Для того чтобы сохранять режим коммерческой тайны, необходимо обязательно использовать решения on-prem, где локально разворачивается собственная модель ИИ. Данные не выходят за пределы корпоративного контура и индексируются при помощи RAG-индексации, с которой потом можно вести диалог в режиме чата.

Сергей Воропаев, генеральный директор ООО «Асилиск»

4 самых безопасных и продуктивных LLM для бизнеса, которые чаще всего используются в закрытых корпоративных системах.

Данные предоставлены Сергеем Воропаевым, генеральным директором ООО «Асилиск»

Представим ситуацию: HR-специалист крупного предприятия готовит годовой кадровый отчет. И, конечно, помощь чат-бота значительно упростит ему задачу. Но ИИ не сможет качественно помочь без большого массива данных об этой компании. Если представить, какое количество сотрудников, имеющих доступ к конфиденциальной информации, используют ИИ для решения рабочих задач, то можно оценить масштаб проблемы. Для корпоративных клиентов, которые нуждаются в том, чтобы их сотрудники использовали ИИ, рекомендуется брать открытые публичные модели, которые можно разворачивать на своих серверах. Например, Mistral AI или LLaMA. Это достаточно дорогостоящий и сложный процесс. Публичные модели нужно внедрять, поддерживать, выдавать доступ определенным сотрудникам. К тому же они немного уступают ChatGPT, но в плане безопасности вы будете застрахованы.

Виктор Попов, эксперт по ИИ, основатель и СЕО проекта BotB2B

Помочь в вопросах безопасности может разработка внутренних положений компании по работе с сервисами искусственного интеллекта. Тогда сотрудники будут понимать, разрешено ли им использовать ИИ для реализации поставленных задач, имеют ли они право упоминать компанию при общении с нейросетью и разглашать какие-либо данные.

Сегодня есть два вида интеллектуальных ассистентов: общедоступные облачные и внутренние разработки, сервисы которых доступны только внутри компании. Как правило, последние требуют меньше входной информации, так как уже интегрированы с нужными информационными системами. Для них достаточно только сформулировать запрос. Однако не в каждой компании есть свои интеллектуальные системы. Сотрудникам приходится использовать общедоступные сервисы. Передавать им конфиденциальные данные ни в коем случае нельзя. Никто не знает, как сервис будет использовать эту информацию. Служба безопасности в компаниях обычно информирует пользователей, что не нужно передавать важные данные через публичные файлообменники. Однако даже безопасники порой забывают о новых сервисах, каковыми являются ИИ-ассистенты. Чтобы хоть как-то обеспечить интернет-безопасность, необходимо включать в напоминания сотрудникам пункты про публичные ИИ-ассистенты.

Максим Антонов, архитектор группы ИТ-компаний TeamIdea

Заключение

Применение искусственного интеллекта может значительно облегчить ведение бизнеса. Однако вместе с преимуществами приходят и новые угрозы. В условиях стремительного развития цифровых технологий только продуманное и ответственное использование ИИ гарантирует защиту конфиденциальной информации.

Источник: www.mvideo.ru